機器學習與預測性維護的 5 個步驟

機器學習是推動下一次工業革命的關鍵。隨著更多的設備和供應鏈加入工業物聯網 (IIoT),原本就日不暇給的人類主管已然無法處理湧入的大量資料,急需可自行調節的自動化功能。以發電廠為例。每一台發電設施均包含各種設備和基礎架構,組成一個複雜又相互依存的生態系統。這些系統集體產生極大量的資料,每日資料量多達 1.5 TB。如此驚人的資料數量已超過人力所能處理範圍,但是機器學習可以游刃有餘的一手包辦。您可以把機器學習設想成人力倍化裝置。機器學習可以取代例常操作,釋出重要的人力資源來從事新的分析任務。例如,機器學習可以即時監測設備並預測維護需求,不再倚賴傳統的維護時程。至於規模更大的話,可考慮將感測器分散安裝在一個監督控制與資料擷取 (SCADA) 系統上。巨量資料系統可以收集和分析這些所有變數,由此建立一個模型來預測整個系統的行為。能夠以這種方式運用大量感測器資料,對於機器的停機時間和維護成本有巨大影響。

機器學習的應用

讓我們回到發電廠的例子。發電站故障可能會對系統產生連鎖效應,造成過載與大面積的停電。2003 年美加東北地區發生停電事件的部份原因歸咎於系統監控故障並牽連整個網路,導致 256 座發電廠全都作業中斷。為了確保恢復能力並避免這類後果,發電廠所連接的發電站和電網必須遵守重大基礎架構防護指導方針。其中,執行預測性維護的能力對此程序尤為緊要。透過部署攝影機、震動感測器、流速感測器和其他裝置,預測性維護系統可以即時監測設備。出現過熱區或是震動模式的細微變動都可能是必須盡早更換泵浦或馬達的前兆。甚至有可能偵測到設備中難以監測的問題。例如,仔細監測下游設備的輸入流速、液體溫度或空穴效應可以顯示出上游設備中未被監測的部件問題。

發展會學習的系統

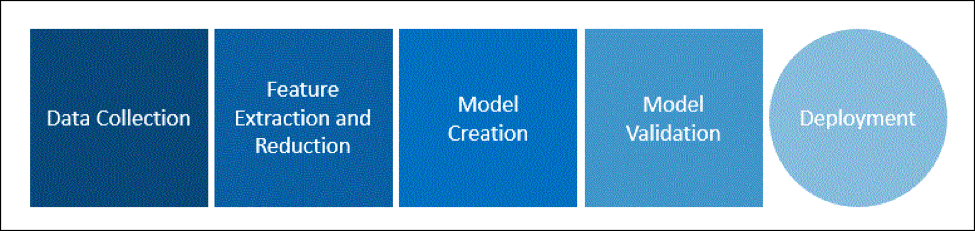

我們把預測性維護與其他機器學習演算法整理成五個步驟的程序,如圖 1 所示。首先收集感測器資料並加以淨化,以便提取出感興趣的項目。接著,開發人員選擇一個學習模型並用收集到的資料來訓練。最後再針對真實世界的新資料來驗證模型的有效性,接著再實地部署。若是模型無法表現出我們想要的行為,則失敗的情況會回饋給模型,用來改善日後的表現。

National Instruments 便是用這個方法塑造 LabVIEW Machine Learning Toolkit 的架構。這個工具組支援各式各樣用來訓練機器學習模型的演算法、通訊協定和程式(虛擬儀控或稱 VI),可發現隱藏在大量資料中的結構。讓我們利用這個工具組來探索模型開發的五個階段。

1. 資料收集

從實地系統開始收集資料是最直接的著手點。如您所預期,LabView 提供一套健全的資料擷取工具,可利用指定實例的資料來訓練模型。但是實地收集資料在實務上並不一定可行,例如,實地系統尚未設定儀控的時候。在這些情境下,Machine Learning Toolkit 也可以利用開放取用的資料集來運作。(NASA 保存一組可用來訓練模型的機器學習資料集。)

要運用擷取到的資料,必須先處理和淨化資料,偵測有否異常狀況並減少錯誤與雜訊。機器學習系統需要辨別並捨棄特定類型的雜訊,是依據監測的設備以及感測器要記錄的資料類型。例如,負責監測特定元件之震動的感測器可能偵測到另一個來源的震動。或者一台攝影機在特定的照明條件下,可能會受許多影像雜訊影響。處理雜訊的方法很多,端看所記錄的資料類型而定,從捨棄異常資料的簡單處理,乃至精密的分析方法皆有。視任務性質與遇到什麼類型的雜訊而定,機器學習演算法會用不同的方式應付這個問題。

2. 提取特徵

要把資料整理好供下游使用,亦需減少特徵數量和進行資料修整 (data smoothing)。例如,在具有大量變數的系統中,通常要提取特徵才能確認相關的資料點。在 LabView 的個案中,可利用若干工具把資料正規化並突顯其模式。維度縮減、偵測異常、群集 (clustering) 與分類演算法搭配運作,產生出整理妥當的資料,隨時可輸入學習系統。憑藉領域專長,資料淨化用的工具包含著重統計資料的群集有效性指數:

- Rand 指數

- Davies-Bouldin (DB) 指數

- Jaccard 指數

- Dunn 指數

此外,尚有用來評估資料分類的工具:

- 分類準確度

- 混淆矩陣

3. 建置模型

機器學習系統主要有兩種學習方式:監督式和非監督式學習。監督式與非監督式學習主要有兩項差別。其一是人類有否參與訓練模型。另一項是模型可以運用哪些類型的資料。監督式學習模型從有預先定義屬性的資料點開始。模型嘗試預測這些資料點之間的關係。預測錯誤的結果會回饋給模型以利改善日後的表現。Machine Learning Toolkit 的監督式學習模型包括:

- k-Nearest Neighbors(k-NN,k 個最鄰近資料點)

- 倒傳遞 (BP) 類神經網路

- 學習向量量化 (LVQ)

- 支援向量機器 (SVM)

非監督式學習會運用無標籤的資料,所以不會有任何錯誤訊號回饋給資料流。這個模式擅長確認相同和不相同的資料之峰值、模式和群集。工具組的非監督式學習模型包括:

- 等距特徵映射 (Isometric Feature Mapping, Isomap)

- 局部線性嵌入 (Locally Linear Embedding, LLE)

- 多維標度法 (Multidimensional Scaling, MDS)

- 主成份分析 (Principal Component Analysis, PCA)

- 核心主成份分析 (Kernal PCA)

- 線性判別分析 (Linear Discriminant Analysis, LDA)

4. 驗證

該 Toolkit 的多步驟工作流程可透過任意多變的複雜的測試案例中反覆執行,以便建構並驗證學習模型,即便是 LabVIEW 面向最終使用者的「前面板」特徵也可處理。具有大型資料流的系統進行驗證時,必須具備可以比較預期行為和實際行為的工具。工具組包含大量資料驗證與視覺化的各項功能:

- 視覺化(2D 和 3D)

- Plot SOM(2D 和 3D)

5 部署

部署需要的不僅是良好的模型,還需要有能力應付運算需求的硬體。例如,LabVIEW 模型可以部署在 NI 的 CompactRIO 系列產品上,而這系列產品搭載雙核心和四核心的 Intel Atom® 處理器。部署之後,Machine Learning Toolkit 支援在邊緣進行即時狀態監測,並控制預測性系統維護的開支。在執行這個程序的每個步驟時,Toolkit 支援各種不同的通訊協議。它亦與 Windows 7+ 和 Linux 相容,表示使用者可以馬上監測與剖析新傳入的資料。

邊緣機器學習

機器學習的長處在於能夠迅速處理非常大量的資料。在高風險、高傳輸量的環境中,模型能否成功端賴它吸納的資訊,這意味著必須安裝很多感測器才能達成學習效果。因為有豐富的感測器數據圖表,從重大事件發生後,機器學習只需更少的時間便取得可據以行動的深入分析,供維護時程、發電廠操作人員和許許多其他產業使用案例使用。透過內聯的網路診斷與分析也可以減少資料處理開支,因為不需要在雲端把大量資料移進移出進行處理與散佈。因為有這些長處,模型憑藉機器學習的精確度,加上反應快的聯網資產作為後援,定能協助工程師和領域專家把大量無條理的資料轉化成可據以行動的資訊,而且就在邊緣完成。